Glaze, développé par l'Université de Chicago, ajoute des balises à leurs œuvres qui confondent l'IA lorsqu'elle réutilise les œuvres des artistes.

Face à l’exploitation effrénée des données par certains développeurs d’IA, les artistes piègent délibérément leurs créations pour les rendre inutilisables, avec l’aide de chercheurs universitaires. Paloma McLean est une peintre américaine. De nombreux programmes d'IA créatifs permettent déjà de créer des images inspirées du style d'une personne, même si l'artiste n'a jamais donné son consentement et n'en tirera aucun bénéfice financier. “Cela m'a dérangé», explique le designer basé à Houston (Texas). “Je ne suis pas un artiste célèbre, mais je n'étais pas à l'aise avec l'idée d'utiliser mon travail à des fins de leadership» Modèle d'intelligence artificielle. Pour remédier à cela, elle gère son entreprise via Glaze, un programme qui ajoute à ses illustrations des pixels, invisibles à l'œil humain, pour perturber le travail de l'intelligence artificielle.

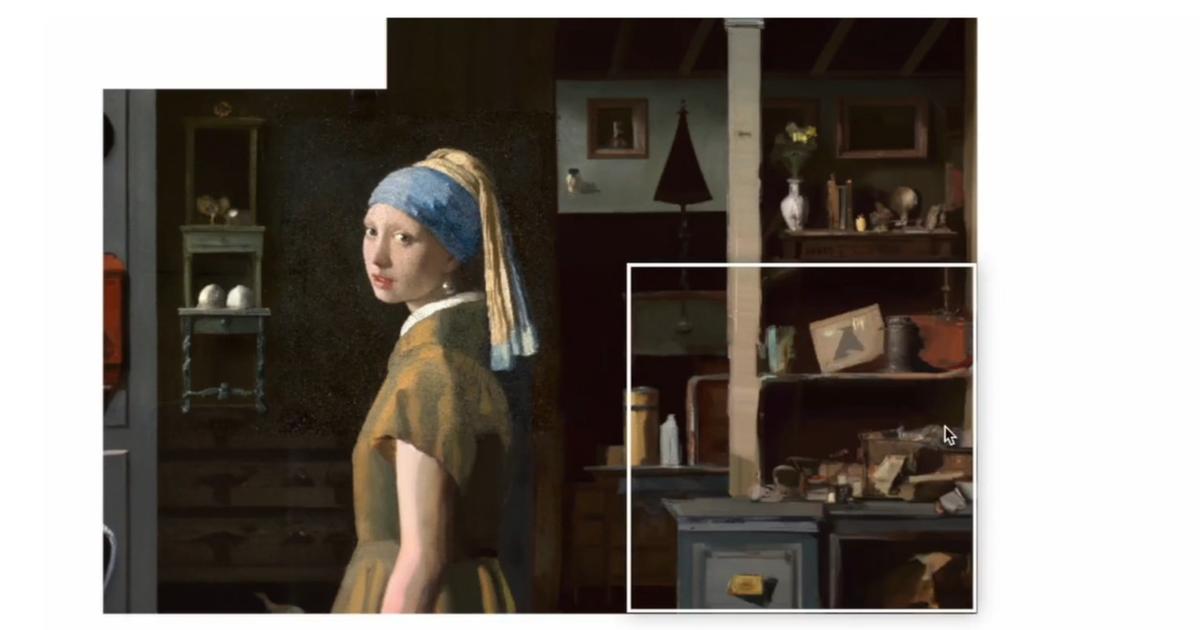

Après ce traitement, les images créées deviennent floues, et les visages sont flous, sans comparaison avec les originaux. “Nous essayons de fournir des outils technologiques pour protéger les créateurs humains contre l'utilisation abusive des modèles d'IA générative.“, explique Ben Zhao, chercheur à l'université de Chicago, qui a créé son équipe glaçage.

Lire aussiLa nouvelle chanson des Beatles est publiée grâce à l'intelligence artificielle le 2 novembre

“un problème dangereux”

Ce professeur d'informatique a été alerté en novembre 2022, et a développé le logiciel en seulement quatre mois, en s'appuyant sur des travaux antérieurs visant à désactiver la reconnaissance faciale. “Nous avons travaillé à plein régime, car nous savions que le problème était graveRaconti Ben Chow. Beaucoup de gens souffraient.»

Les géants de l’IA générative ont conclu des accords pour garantir les droits d’utilisation de certains contenus, mais la grande majorité des données, images, textes ou sons utilisés pour développer des modèles ont été réalisés sans consentement explicite. Depuis son lancement, Glaze a été téléchargé plus de 1,6 million de fois, selon le chercheur dont l'unité s'apprête à lancer un nouveau programme baptisé Nightshade.

Il se concentre sur des requêtes linguistiques simples (invites) envoyées par un utilisateur d'un modèle d'IA génératif pour obtenir une nouvelle image. Elle vise à faire dérailler l'algorithme, qui affichera alors, par exemple, l'image d'un chat lorsqu'un chien est demandé.

Une autre initiative, la startup Spawning, a développé Kudurru, un logiciel qui détecte les tentatives de foule sur les plateformes photo. L’artiste a alors la possibilité de bloquer l’accès à son œuvre ou d’envoyer une image autre que celle demandée.Ce qui équivaut à un empoisonnement» Le modèle d'IA est en cours de développement et affecte sa fiabilité, décrit Jordan Mayer, co-fondateur de Spawning. Plus d'un millier de sites Internet ont déjà été intégrés au réseau Kudurru.

Le couvoir a également été créé, ai-je été formé ? (haveibeentrained.com), un site qui vérifie si des images ont été introduites dans un modèle d'IA et donne à leur propriétaire la possibilité de les protéger contre toute utilisation non autorisée à l'avenir. Au-delà de l’image, des chercheurs de l’université de Washington à Saint-Louis (Missouri) se sont intéressés au son et ont développé AntiFake.

” L'objectif est que les gens puissent protéger leur contenu, qu'il s'agisse d'artistes individuels ou d'entreprises possédant une quantité importante de propriété intellectuelle. »,

Bin Zhao, chercheur à l'Université de Chicago

Ce logiciel enrichit un fichier audio avec des sons supplémentaires imperceptibles à l'oreille humaine, rendant impossible une imitation fiable de la voix humaine, explique Qiyuan Yu, le doctorant à l'origine du projet. Le programme vise notamment à prévenir “Contrefaçons profondes», des montages photo ou des vidéos très réalistes qui utilisent l'apparence d'une personne, souvent célèbre, pour lui faire faire ou dire quelque chose.

L'équipe, supervisée par le professeur Ning Zhang, a été récemment contactée par les producteurs du podcast à succès qui souhaitaient le protéger contre toute appropriation illicite, selon Ziyuan Yu. Même si pour l'instant, il n'est utilisé que pour le langage parlé, AntiFake peut aussi protéger la voix des chanteurs, estime le chercheur dont le logiciel est accessible gratuitement.

L'unité de Ben Zhao a été approchée par “De nombreuses entreprises souhaitent utiliser Nightshade pour préserver leurs images et leur propriété intellectuelle», selon l'universitaire de Chicago. Il n'est même pas contre les grandes entreprises qui utilisent son logiciel.

“L'objectif est que les gens puissent protéger leur contenu, qu'il s'agisse d'artistes individuels ou d'entreprises possédant une quantité importante de propriété intellectuelle.“Dans le cas de la ponte, l'idée n'est pas seulement de faire obstacle, mais aussi, deuxièmement”, explique Ben Zhao.Permettre aux gens de s’organiser pour vendre leurs données contre rémunération», précise Jordan Mayer, qui annonce le lancement de la plateforme début 2024.meilleure solutionSelon lui,Ce sera un monde où toutes les données utilisées pour l’IA seront soumises à approbation et paiement. Nous espérons pousser les développeurs dans cette direction.»

“Impossibile scrivere con i guantoni da boxe. Organizzatore freelance. Analista appassionato. Amichevole piantagrane. Drogato di pancetta.”