Un team della Duke University ha creato un dispositivo audio che traduce i segnali cerebrali in parole, aiutando le persone con disturbi neurologici. Sebbene sia ancora più lenta del linguaggio naturale, questa tecnologia, supportata da sensori cerebrali avanzati e dalla ricerca in corso, mostra un potenziale promettente per migliorare le capacità di comunicazione. (Concetto dell'artista) Credito: Issues.fr.com

Una protesi decodifica i segnali provenienti dal centro del linguaggio del cervello per prevedere il suono che una persona sta cercando di dire.

Un team di neuroscienziati, neurochirurghi e ingegneri della Duke University ha sviluppato una protesi vocale in grado di convertire i segnali cerebrali in parole.

La nuova tecnologia, dettagliata in un recente articolo sulla rivista Comunicazioni naturaliOffre speranza alle persone con disturbi neurologici che compromettono la parola, consentendo loro di comunicare tramite un'interfaccia cervello-computer.

Affrontare le sfide comunicative legate ai disturbi neurologici

“Molti pazienti soffrono di disturbi del movimento debilitanti, come la sclerosi laterale amiotrofica (SLA) o la sindrome del lock-in, che possono compromettere la loro capacità di parlare”, ha affermato Gregory Kogan, Ph.D., professore di neurologia alla Duke University. Facoltà di Medicina e uno dei principali ricercatori coinvolti nel progetto. “Ma gli strumenti attualmente disponibili per consentire loro di comunicare sono generalmente molto lenti e macchinosi”.

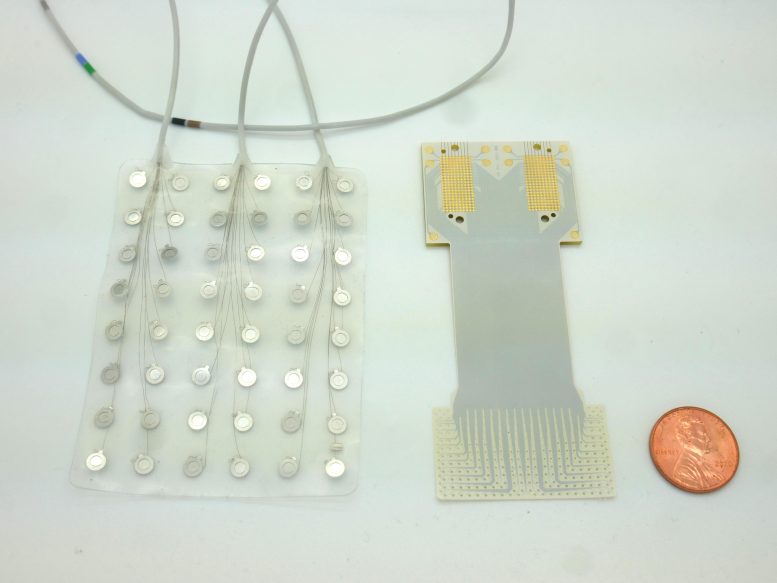

Un dispositivo non più grande di un francobollo (la parte tratteggiata in una striscia bianca) contiene 128 sensori microscopici in grado di tradurre l'attività delle cellule cerebrali in ciò che una persona intende dire. Credito: Dan Vahaba/Duke University

Immagina di ascoltare un audiolibro a velocità dimezzata. Questa è la migliore velocità di decodifica vocale attualmente disponibile, circa 78 parole al minuto. Tuttavia, le persone parlano circa 150 parole al minuto.

La discrepanza tra velocità del parlato e velocità di decodificazione è dovuta in parte al numero relativamente piccolo di sensori di attività cerebrale che possono essere integrati in un pezzo di materiale sottilissimo posto sulla superficie del cervello. Meno sensori forniscono informazioni meno decifrabili.

Migliorare la decodifica dei segnali cerebrali

Per migliorare le limitazioni precedenti, Kogan ha collaborato con Jonathan Vivente, Ph.D., membro della facoltà del Duke Brain Science Institute, il cui laboratorio di ingegneria biomedica è specializzato nella fabbricazione di sensori cerebrali ad alta e ultra-alta densità. flessibile.

Rispetto alle attuali protesi acustiche contenenti 128 elettrodi (a sinistra), gli ingegneri della Duke University hanno sviluppato un nuovo dispositivo in grado di ospitare il doppio dei sensori in uno spazio molto più piccolo. Credito: Dan Vahaba/Duke University

In questo progetto, Vivinti e il suo team hanno confezionato 256 microscopici sensori cerebrali su un pezzo di plastica flessibile di grado medico, grande quanto un francobollo. I neuroni separati da un granello di sabbia possono avere schemi di attività molto diversi quando coordinano il linguaggio. È quindi necessario distinguere i segnali provenienti dalle cellule cerebrali vicine per contribuire a fare previsioni accurate sul discorso previsto.

Studi clinici e sviluppi futuri

Dopo aver prodotto il nuovo impianto, Kogan e Vivinti hanno collaborato con diversi neurochirurghi presso il Duke University Hospital, tra cui Derek Southwell, MD, PhD, Nandan Ladd, MD, PhD e Alan Friedman, MD, che hanno aiutato a reclutare quattro pazienti. Per testare gli impianti. Lo studio ha chiesto ai ricercatori di posizionare temporaneamente il dispositivo in pazienti sottoposti a intervento chirurgico al cervello per un'altra malattia, come il trattamento del morbo di Parkinson o la rimozione di un tumore. Kogan e il suo team hanno avuto poco tempo per testare il dispositivo in sala operatoria.

“Mi piace paragonarlo a un equipaggio NASCAR”, ha detto Coogan. “Non volevamo aggiungere ulteriore tempo alle procedure operatorie, quindi dovevamo entrare e uscire entro 15 minuti. Non appena il chirurgo e il team medico hanno detto 'Vai!'” siamo intervenuti e il paziente ha completato l'operazione .

Il compito consiste in una semplice attività di ascolto e ripetizione. I partecipanti hanno sentito una serie di parole senza senso, come “ava”, “kug” o “vip”, e poi le hanno pronunciate ad alta voce. Il dispositivo ha registrato l'attività della corteccia motoria del linguaggio di ciascun paziente, coordinando quasi 100 muscoli che muovono le labbra, la lingua, la mascella e la laringe.

Quindi, Sosendrakumar Duraivel, primo autore del nuovo rapporto e studente laureato in ingegneria biomedica alla Duke University, ha preso i dati neurali e acustici dalla sala operatoria e li ha inseriti in Apprendimento automatico Un algoritmo per prevedere con precisione il suono prodotto, basato esclusivamente sulle registrazioni dell'attività cerebrale.

In laboratorio, Ph.D. della Duke University. Il candidato Kumar Duraivel analizza un insieme colorato di dati sulle onde cerebrali. Ogni ombra e linea rappresenta l'attività di uno dei 256 sensori, tutti registrati in tempo reale dal cervello del paziente in sala operatoria. Credito: Dan Vahaba/Duke University

Per alcuni suoni e participi, come la /g/ nella parola “gak”, il decodificatore rispondeva correttamente nell'84% dei casi quando era il primo suono di una serie di tre suoni che componevano una parola senza senso.

Tuttavia, la precisione diminuiva quando il decodificatore analizzava i suoni nel mezzo o alla fine di una parola senza senso. Era anche difficile avere due suoni simili, come /p/ e /b/.

Nel complesso, il decodificatore è risultato accurato nel 40% dei casi. Questo può sembrare un risultato di test modesto, ma è stato davvero impressionante considerando che risultati tecnici simili, dal trasferimento del cervello alla parola, richiedono ore o giorni di dati per essere sfruttati. Tuttavia, l'algoritmo di decodifica audio utilizzato da Duraivel ha funzionato con soli 90 secondi di dati audio da un test di 15 minuti.

Duravel e i suoi mentori sono entusiasti di creare una versione wireless del dispositivo grazie a una recente sovvenzione di 2,4 milioni di dollari da parte di Istituto Nazionale della Salute.

“Attualmente stiamo sviluppando lo stesso tipo di dispositivo di registrazione, ma senza cavi”, ha detto Kogan. “Sarai in grado di muoverti senza dover essere legato a una presa elettrica, il che è davvero emozionante.” »

Sebbene il loro lavoro sia incoraggiante, c'è ancora molta strada da fare prima che il dispositivo protesico vocale di Viventi e Cogan arrivi presto sugli scaffali.

“Siamo a un punto in cui il parlato è ancora molto più lento del parlato naturale, ma puoi vedere il percorso attraverso il quale puoi arrivarci”, ha detto Vivinity in un recente articolo della rivista Duke sulla tecnologia.

Questo lavoro è stato sostenuto da sovvenzioni del National Institutes of Health (R01DC019498, UL1TR002553), del Dipartimento della Difesa (W81XWH-21-0538), della Fondazione Klingenstein-Simons e di un Incubator Award del Duke Brain Science Institute.

“Fanatico di zombi da una vita. Praticante di web hardcore. Pensatore. Esperto di musica. Studioso di cultura pop impenitente.”